Como estava esse conteúdo?

Ver é compreender: Twelve Labs é pioneira em inteligência de vídeo com IA na AWS

A visão é o sentido dominante na maioria dos seres humanos e tem um impacto profundo na forma como interpretamos o mundo à nossa volta. O que percebemos, como aprendemos, pensamos e navegamos pelo nosso ambiente é tudo fortemente mediado pela visão. Mas mesmo aqueles que são abençoados com uma visão perfeita são limitados pela quantidade de informação que o córtex visual consegue processar num determinado momento. Felizmente, a tecnologia pode ir além do que a biologia oferece.

A Twelve Labs é uma startup em rápido crescimento que usa IA generativa para processar grandes quantidades de dados de vídeo, capacitando seus clientes com inteligência de vídeo de última geração. A empresa está treinando e escalando modelos de IA multimodal na AWS que são capazes de interpretar dados visuais como nós, em uma escala possibilitada por tecnologia inovadora e experiência comprovada.

Colocando uma ideia geral em movimento

A Twelve Labs é uma startup sul-coreana focada em inteligência de vídeo alimentada por IA. A empresa foi cofundada por Jae Lee em 2020 e possui escritórios em Seul e São Francisco. “A Twelve Labs é uma empresa de pesquisa e produtos de IA que desenvolve modelos básicos de vídeo para empresas e desenvolvedores”, afirma Lee. “Mesmo antes de aprendermos a falar ou escrever, reunimos muitos aspectos diferentes do mundo por meio dos dados sensoriais obtidos ao interagir com ele, e acreditamos que essa é a melhor maneira de construir modelos.”

A Twelve Labs foi fundada numa época em que o mercado emergente de IA se concentrava principalmente em texto ou imagens. “Quando começamos a empresa, as pessoas não falavam muito sobre multimodalidade nem usavam o termo ‘modelo de base’. Víamos uma tendência de laboratórios e empresas tentando abordar a inteligência por meio da compreensão da linguagem. Mas então vimos uma oportunidade — e, francamente, um desafio muito difícil — em abordar o vídeo. Foi quando começamos a trabalhar no raciocínio perceptivo.”

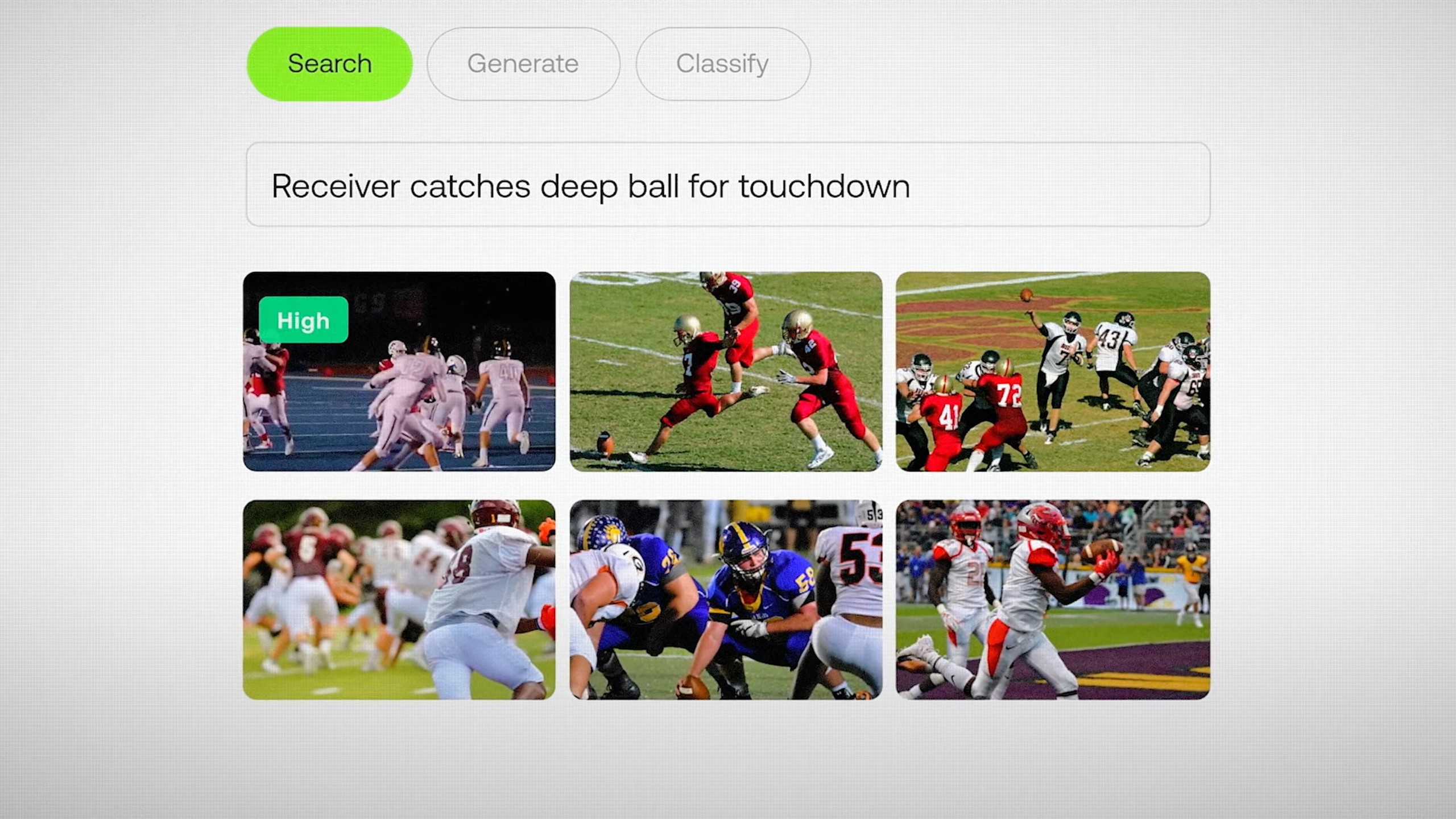

“Nossa área de foco é em problemas tradicionais de compreensão de vídeo, como pesquisa semântica em grandes arquivos, classificação, chat por vídeo e até mesmo agentes de vídeo e geração aumentada via Recuperação (RAG)”, diz Lee. ”Se você tem muitos dados de vídeo e precisa pesquisar coisas muito rapidamente, a API da Twelve Labs permite que você faça isso em minutos.” Hoje, mais de 30.000 desenvolvedores e empresas estão usando os modelos da Twelve Labs, incluindo marcas influentes como a NFL.

Gerando insights quadro a quadro

A Twelve Labs oferece dois modelos, Marengo e Pegasus. “O Marengo é dedicado a gerar incorporações de vídeo multimodais ricas que permitem alimentar qualquer recuperação, ou seja, imagens, áudio, vídeo e texto”, diz Lee. “O Pegasus é o nosso modelo de linguagem de vídeo, capaz de combinar prompts do usuário e as incorporações que o Marengo gera para responder às perguntas do usuário, gerar relatórios e muito mais.”

“Fazemos muitas pesquisas inovadoras sobre modelos de arquitetura mais adequados para vídeo. Existem vários modelos de incorporação de texto e imagem, mas o vídeo é algo completamente diferente. Essa é a parte da pesquisa, mas o trabalho de engenharia ainda precisa ser feito”, diz Lee.

Felizmente, as startups de IA estão acostumadas a enfrentar desafios técnicos significativos, e a Twelve Labs não é diferente. “Efetivamente, 80% dos dados do mundo são vídeos, o que equivale a mais de 100 zettabytes de conteúdo de vídeo que usamos primeiro para treinar, indexar e compreender”, diz Lee. “O desafio aqui é a escala.” A Twelve Labs está trabalhando com a AWS para superar esse desafio com acesso à tecnologia e à experiência necessárias para atingir seus objetivos.

Potenciando o raciocínio perceptivo com tecnologia inovadora

A Twelve Labs está usando o Amazon SageMaker HyperPod para treinar e escalar seus modelos com mais eficiência. As empresas usam o SageMaker HyperPod para treinar FMs por semanas ou até meses, enquanto monitoram ativamente a integridade do cluster e aproveitam a resiliência automatizada de nós e tarefas. Se um nó com defeito é detectado, ele é substituído automaticamente e o treinamento do modelo é retomado, economizando até 40% do tempo de treinamento.

“Um dos maiores desafios na construção desses modelos é que estamos trabalhando com máquinas realmente poderosas em uma escala incrível, de centenas de GPUs a dezenas de milhares de CPUs”, diz Lee. ”Embora essas máquinas sejam muito bem construídas e robustas, há muitas falhas de hardware e de nós.”

“Trabalhamos em estreita colaboração com a equipe do SageMaker HyperPod. Aproveitamos a resiliência e a infraestrutura de treinamento distribuída que a AWS construiu, o que nos permite ativar GPUs, treinar nossos modelos o mais rápido possível e enviá-los”, diz Lee. ”A resiliência do SageMaker HyperPod, a capacidade de corrigir nós inoperantes e, basicamente, terceirizar a computação de alto desempenho foi realmente atraente para nós.”

A equipe da Twelve Labs também utiliza o AWS Elemental MediaConvert para transcodificação de vídeo baseada em nuvem, eliminando a necessidade de manter uma infraestrutura de processamento de vídeo. “A infraestrutura de streaming do AWS Elemental MediaConvert nos permite focar no que realmente sabemos fazer”, afirma Lee.

A Twelve Labs também oferece integração profunda com o Amazon Simple Storage Service (Amazon S3), um serviço de armazenamento de objetos que oferece escalabilidade, disponibilidade de dados, segurança e desempenho líderes do setor. “Nossos clientes realmente apreciam a integração perfeita entre os fluxos de trabalho da Twelve Labs e do S3”, afirma Lee. “Se você armazena a grande maioria dos seus dados no S3, podemos extrair seus dados de vídeo, indexá-los, incorporá-los e habilitar a pesquisa sem atrito.”

Colocando o crescimento em foco

A AWS também ajudou a Twelve Labs a impulsionar seu crescimento por meio do AWS Activate, um programa emblemático que oferece créditos na nuvem, suporte técnico e orientação empresarial para startups. A equipe da AWS Startups é composta por fundadores, criadores e visionários que não apenas entendem os desafios de administrar uma startup, mas também já passaram por isso e têm experiência para apoiar outras pessoas ao longo de sua jornada. Isso inclui encontrar os serviços da AWS certos para seu caso de uso, financiar uma prova de conceito inicial e muito mais.

Uma parte fundamental do AWS Activate é ajudar startups a desenvolver estratégias de entrada no mercado e aumentar a exposição a novos clientes. Como parte desse processo, a Twelve Labs se juntou ao AWS Marketplace, uma loja digital com curadoria que permite à empresa fornecer seus serviços de inteligência de vídeo de maneira integrada a uma base global de clientes. Empresas de todos os tamanhos agora podem usar o AWS Marketplace para encontrar, experimentar, comprar, implantar e gerenciar produtos da Twelve Labs rapidamente.

IA que vê o mundo como nós

No futuro, a Twelve Labs continuará a colaborar com a AWS e a abrir novos caminhos na inteligência de vídeo com tecnologia de IA. “A razão mais convincente para estarmos entusiasmados com a parceria com a AWS é a empatia compartilhada pelos nossos clientes, que lidam com petabytes — ou até exabytes — de dados de vídeo”, afirma Lee.

“A AWS nos deu o poder de computação e o suporte para resolver os desafios da IA multimodal e tornar o vídeo mais acessível, e esperamos uma colaboração frutífera nos próximos anos, à medida que continuamos nossa inovação e expansão global”, diz Lee. ”Podemos acelerar o treinamento do nosso modelo, entregar nossa solução com segurança a milhares de desenvolvedores em todo o mundo e controlar os custos de computação, tudo isso enquanto expandimos os limites da compreensão e criação de vídeo usando IA generativa.”

Como parte de um Acordo de Colaboração Estratégica (SCA) de três anos, a empresa está agora trabalhando com a AWS para aprimorar ainda mais seus recursos de treinamento de modelos e implantar seus modelos em novos setores, como saúde e manufatura. “Queremos ser o córtex visual de todos os futuros agentes de IA — agentes que precisam ver o mundo da mesma forma que nós”, diz Lee.

Como estava esse conteúdo?