Com'era questo contenuto?

Vedere è capire: Twelve Labs è il pioniere dell'intelligenza video IA su AWS

La vista è il senso dominante nella maggior parte degli esseri umani e ha un profondo impatto sul modo in cui interpretiamo il mondo che ci circonda. Ciò che percepiamo, il modo in cui apprendiamo, pensiamo e ci muoviamo nell'ambiente circostante è tutto fortemente mediato dalla visione. Ma anche chi possiede una vista perfetta è limitato dalla quantità di informazioni che la corteccia visiva è in grado di elaborare in un dato momento. Fortunatamente, la tecnologia può andare oltre ciò che offre la biologia.

Twelve Labs è una startup in rapida crescita che utilizza l'IA generativa per elaborare grandi quantità di dati video, offrendo ai propri clienti un'intelligenza video di nuova generazione. L'azienda sta addestrando e sviluppando modelli di IA multimodali su AWS in grado di interpretare i dati visivi come facciamo noi, su una scala resa possibile da una tecnologia innovativa e da una comprovata esperienza.

Mettere in moto un'idea di ampio respiro

Twelve Labs è una startup sudcoreana focalizzata sull'intelligenza video basata sull'IA. L'azienda è stata co-fondata da Jae Lee nel 2020 e ha uffici a Seoul e San Francisco. “Twelve Labs è una società di ricerca e prodotti di intelligenza artificiale che crea modelli di fondazione video per aziende e sviluppatori”, afferma Lee. “Ancor prima di imparare a parlare o scrivere, raccogliamo molti aspetti diversi del mondo attraverso i dati di input sensoriali interagendo con essi, e pensiamo che questo sia il modo migliore per costruire modelli.”

Twelve Labs è stata fondata in un'epoca in cui il fiorente mercato dell'IA si concentrava principalmente su testo o immagini. “Quando abbiamo fondato l'azienda, la gente non parlava di multimodale e non usava nemmeno il termine “modello di fondazione”. Stavamo assistendo a questa tendenza di laboratori e aziende che cercavano di affrontare l'intelligenza attraverso la comprensione del linguaggio. Ma poi abbiamo visto un'opportunità, e francamente anche una sfida davvero ardua, nell'affrontare i video. È stato allora che abbiamo iniziato a lavorare sul ragionamento percettivo.”

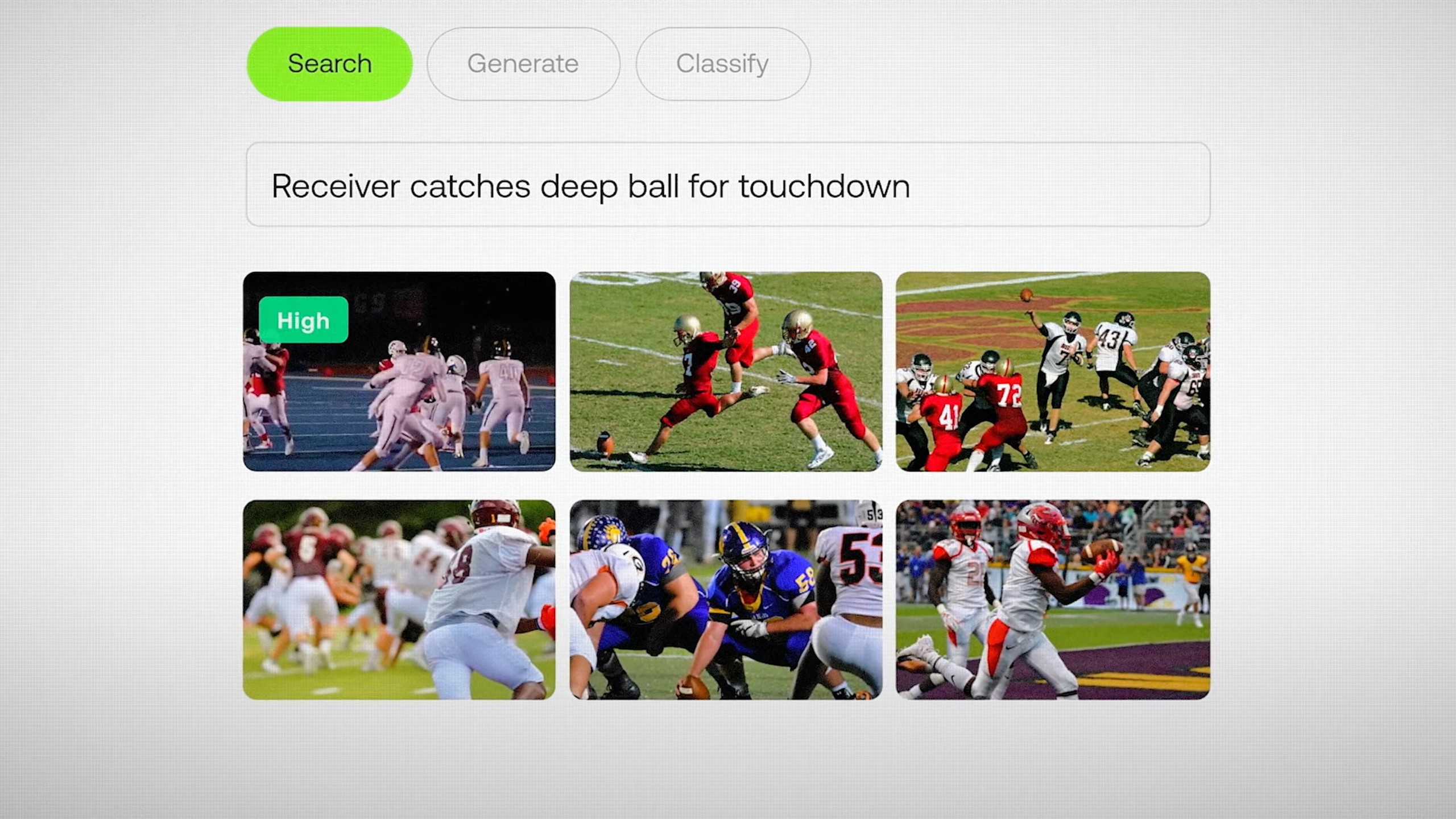

“La nostra area di interesse riguarda i tradizionali problemi di comprensione dei video come la ricerca semantica in archivi di grandi dimensioni o la classificazione, le chat video e persino gli agenti video e la Retrieval-Augmented Generation (RAG)”, afferma Lee. “Se disponi di molti dati video devi essere in grado di cercare le cose molto velocemente, l'API di Twelve Labs ti permette di farlo in pochi minuti”. Oggi più di 30.000 sviluppatori e aziende utilizzano i modelli di Twelve Labs, compresi marchi influenti come la NFL.

Generazione di informazioni fotogramma per fotogramma

Twelve Labs offre due modelli, Marengo e Pegasus. “Marengo si dedica alla generazione di embedding video multimodali che consentono di potenziare qualsiasi ricerca, ovvero immagini, audio, video e testo”, afferma Lee. “Pegasus è il nostro modello di linguaggio video, in grado di combinare le richieste degli utenti e gli embedding generati da Marengo per rispondere alle domande degli utenti, generare report e altro ancora.”

“Facciamo molte nuove ricerche sui modelli di architettura più adatti ai video. Esistono molti modelli di embedding di testo e immagini, ma il video è una bestia completamente diversa. Questo è il lato della ricerca, ma il grandissimo lavoro ingegneristico deve ancora essere svolto”, afferma Lee.

Fortunatamente, le startup che si occupano di IA sono abituate ad affrontare sfide tecniche importanti e Twelve Labs non è da meno. “L'80% dei dati mondiali è costituito da video, il che equivale a oltre 100 zettabyte di contenuti video che usiamo per addestrare, indicizzare e comprendere”, spiega Lee. “La sfida è rappresentata dalla vastità della scala”. Twelve Labs sta collaborando con AWS per superare questa sfida, grazie all'accesso alla tecnologia e alle competenze necessarie per raggiungere i suoi obiettivi.

Potenziare il ragionamento percettivo con una tecnologia innovativa

Twelve Labs utilizza Amazon SageMaker HyperPod per addestrare e scalare i suoi modelli in modo più efficiente. Le aziende utilizzano SageMaker HyperPod per addestrare gli FM per settimane o addirittura mesi, monitorando attivamente lo stato dei cluster e sfruttando la resilienza automatizzata dei nodi e dei lavori. Se viene rilevato un nodo difettoso, questo viene sostituito automaticamente e l'addestramento dei modelli riprende, il che consente di risparmiare fino al 40% del tempo di addestramento.

“Uno degli aspetti più difficili della creazione di questi modelli è che stiamo lavorando con macchine davvero potenti su una scala incredibile, da centinaia di GPU a decine di migliaia di CPU”, afferma Lee. “Anche se queste macchine sono davvero ben costruite e robuste, ci sono molti guasti all'hardware e ai nodi.”

“Lavoriamo a stretto contatto con il team di SageMaker HyperPod. Sfruttiamo la resilienza e l'infrastruttura di addestramento distribuita di AWS, che ci consente di attivare le GPU, addestrare i nostri modelli il più rapidamente possibile e spedirli”, afferma Lee. “La resilienza di SageMaker HyperPod, la capacità di riparare i nodi morti e di esternalizzare l'elaborazione ad alte prestazioni erano davvero interessanti per noi.”

Il team di Twelve Labs sfrutta anche AWS Elemental MediaConvert per la transcodifica video basata su cloud, eliminando la necessità di mantenere l'infrastruttura di elaborazione video. “L'infrastruttura di streaming AWS Elemental MediaConvert ci consente di concentrarci su ciò in cui siamo veramente bravi”, afferma Lee.

Twelve Labs offre inoltre una profonda integrazione con Amazon Simple Storage Service (Amazon S3), un servizio di storage di oggetti che fornisce scalabilità, disponibilità dei dati, sicurezza e prestazioni leader del settore. “I nostri clienti apprezzano molto la perfetta integrazione dei flussi di lavoro Twelve Labs e S3”, afferma Lee. “Se archiviate la maggior parte dei vostri dati su S3, possiamo estrarre senza problemi i dati video, indicizzarli, incorporarli e consentire una ricerca senza problemi.”

Concentrarsi sulla crescita

AWS ha inoltre aiutato Twelve Labs a potenziare la crescita attraverso AWS Activate, un programma di punta che fornisce crediti cloud, supporto tecnico e tutoraggio aziendale per le startup. Il team di Startup AWS è composto da fondatori, costruttori e visionari che non solo comprendono le sfide della gestione delle startup, ma le hanno vissute e hanno l'esperienza necessaria per supportare gli altri durante il loro percorso. Ciò include la ricerca dei servizi AWS giusti per il loro caso d'uso, il finanziamento di un proof-of-concept iniziale e altro ancora.

Una parte fondamentale di AWS Activate è aiutare le startup a sviluppare strategie di go-to-market e aumentare l'esposizione a nuovi clienti. Come parte di questo processo, Twelve Labs è entrato a far parte di AWS Marketplace, una vetrina digitale curata che consente all'azienda di fornire facilmente i propri servizi di intelligenza video a una base clienti globale. Le aziende di tutte le dimensioni possono ora utilizzare AWS Marketplace per trovare, provare, acquistare, distribuire e gestire rapidamente i prodotti Twelve Labs.

L'IA che vede il mondo come lo vediamo noi

In futuro, Twelve Labs continuerà a collaborare con AWS e ad aprire nuovi orizzonti nel campo dell'intelligenza artificiale video. “Il motivo più convincente per essere entusiasti di lavorare con AWS è la condivisione dell'empatia con i nostri clienti che hanno a che fare con petabyte o addirittura exabyte di dati video”, afferma Lee.

“AWS ci ha fornito la potenza di calcolo e il supporto per risolvere le sfide dell'IA multimodale e rendere i video più accessibili, e ci auguriamo una proficua collaborazione nei prossimi anni mentre continuiamo a innovare e a espanderci a livello globale”, afferma Lee. “Possiamo accelerare l'addestramento dei nostri modelli, fornire la nostra soluzione in modo sicuro a migliaia di sviluppatori in tutto il mondo e controllare i costi di calcolo, il tutto superando i limiti della comprensione e della creazione di video utilizzando l'IA generativa.”

Nell'ambito di uno Strategic Collaboration Agreement (SCA) triennale, l'azienda sta ora collaborando con AWS per migliorare ulteriormente le sue capacità di addestramento dei modelli e implementare i modelli in nuovi settori come l'assistenza sanitaria e la produzione. “Vogliamo essere la corteccia visiva per tutti i futuri agenti IA, agenti che hanno bisogno di vedere il mondo come lo vediamo noi”, afferma Lee.

Com'era questo contenuto?