Wie war dieser Inhalt?

Sehen heißt verstehen: Twelve Labs leistet Pionierarbeit im Bereich KI-Video-Intelligenz in AWS

Das Sehen ist der dominierende Sinn des Menschen und hat einen tiefgreifenden Einfluss darauf, wie wir die Welt um uns herum interpretieren. Was wir wahrnehmen, wie wir lernen, denken und uns in unserer Umgebung zurechtfinden, wird stark vom Sehsinn beeinflusst. Aber selbst Menschen mit perfektem Sehvermögen sind dadurch eingeschränkt, wie viele Informationen der visuelle Kortex in einem bestimmten Moment verarbeiten kann. Glücklicherweise kann die Technologie über die Grenzen der Biologie hinausgehen.

Twelve Labs ist ein schnell wachsendes Startup, das generative KI zur Verarbeitung großer Mengen von Videodaten einsetzt und seinen Kunden damit Video-Intelligenz der nächsten Generation bietet. Das Unternehmen trainiert und skaliert multimodale KI-Modelle in AWS, die visuelle Daten so interpretieren können wie wir – in einer Größenordnung, die durch innovative Technologie und bewährtes Fachwissen ermöglicht wird.

Eine große Idee in die Tat umsetzen

Twelve Labs ist ein südkoreanisches Startup, das sich auf KI-gestützte Video-Intelligenz spezialisiert hat. Das Unternehmen wurde 2020 von Jae Lee mitbegründet und hat Niederlassungen in Seoul und San Francisco. „Twelve Labs ist ein KI-Forschungs- und Produktunternehmen, das Video-Basismodelle für Unternehmen und Entwickler erstellt“, sagt Lee. „Noch bevor wir sprechen oder schreiben lernen, sammeln wir durch die Interaktion mit der Welt viele verschiedene Aspekte über die sensorischen Eingabedaten, und wir glauben, dass dies der bessere Weg ist, um Modelle zu erstellen.“

Twelve Labs wurde zu einer Zeit gegründet, als sich der aufstrebende KI-Markt hauptsächlich auf Text oder Bilder konzentrierte. ‚Als wir das Unternehmen gründeten, sprach noch niemand wirklich über Multimodalität oder verwendete den Begriff „Basismodell“. Wir beobachteten den Trend, dass Labore und Unternehmen versuchten, Intelligenz durch Sprachverständnis zu erreichen. Aber dann sahen wir eine Chance – und, um ehrlich zu sein, auch eine wirklich große Herausforderung – in der Bearbeitung von Videos. Damals begannen wir mit der Arbeit am perzeptuellen Schlussfolgern.“

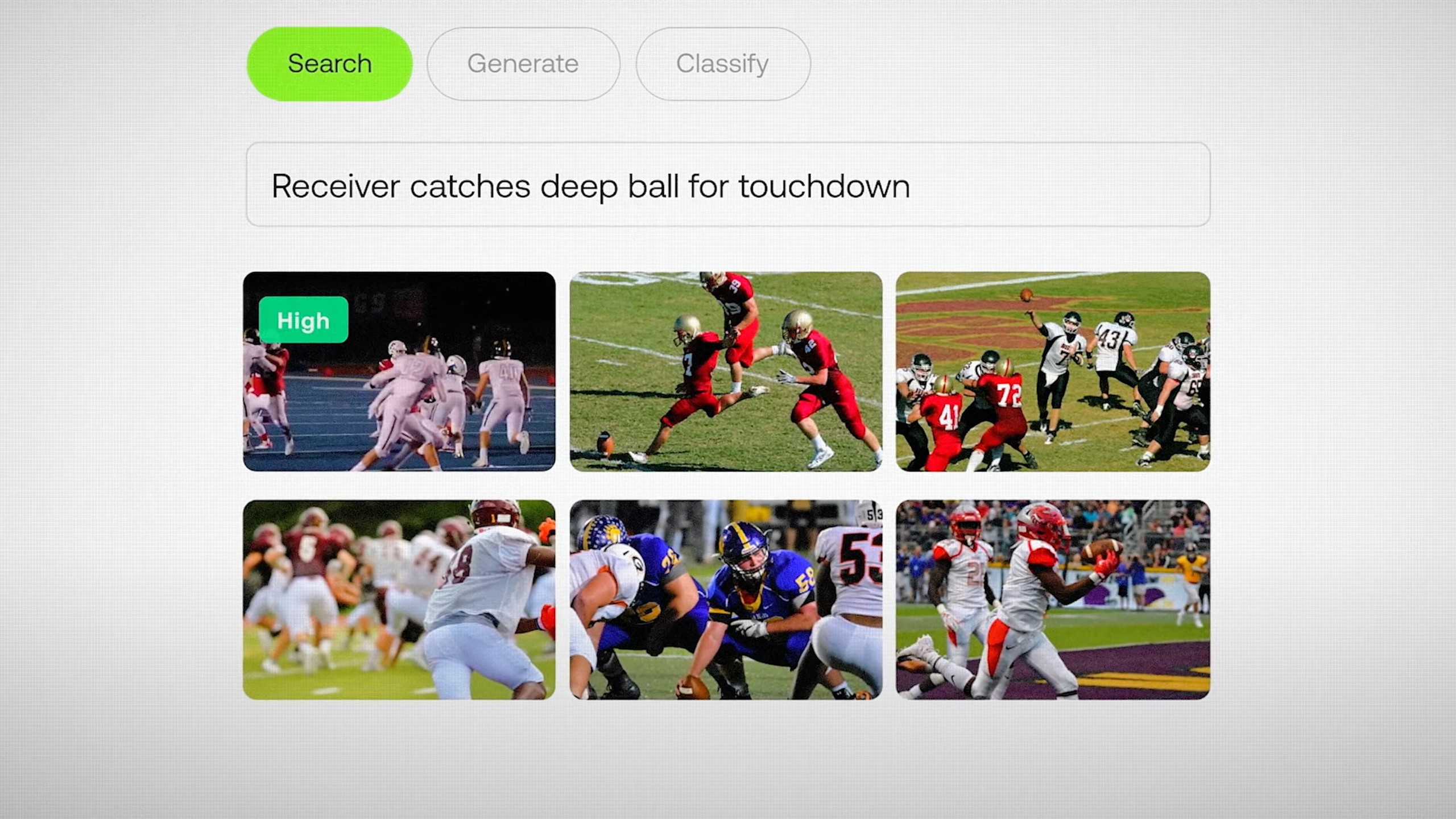

„Unser Schwerpunkt liegt auf traditionellen Problemen des Videoverständnisses wie der semantischen Suche in großen Archiven, der Klassifizierung, dem Video-Chat – sogar Video-Agenten und Retrieval Augmented Generation (RAG)“, sagt Lee. „Wenn Sie über große Mengen an Videodaten verfügen und diese sehr schnell durchsuchen müssen, können Sie dies mit der API von Twelve Labs in wenigen Minuten erledigen.“ Heute nutzen mehr als 30 000 Entwickler und Unternehmen die Modelle von Twelve Labs, darunter einflussreiche Marken wie die NFL.

Insights Frame für Frame generieren

Twelve Labs bietet zwei Modelle an: Marengo und Pegasus. „Marengo ist auf die Generierung reichhaltiger multimodaler Videoeinbettungen spezialisiert, mit denen Sie beliebige Inhalte abrufen können, also Bilder, Audio, Video und Text“, erklärt Lee. „Pegasus ist unser Videosprachmodell, das Benutzer-Prompts und die von Marengo generierten Einbettungen kombinieren kann, um Benutzerfragen zu beantworten, Berichte zu erstellen und vieles mehr.“

„Wir betreiben viel neuartige Forschung zu Architekturmodellen, die besser für Videos geeignet sind. Es gibt eine Reihe von Einbettungsmodellen für Text und Bilder, aber Videos sind eine ganz andere Sache. Das ist die Forschungsseite der Medaille – aber die eigentliche technische Arbeit muss noch geleistet werden“, sagt Lee.

Glücklicherweise sind KI-Startups daran gewöhnt, große technische Herausforderungen zu meistern, und Twelve Labs bildet da keine Ausnahme. „Effektiv bestehen 80 Prozent der weltweiten Daten aus Videos, was einer Menge von über 100 Zettabyte an Videoinhalten entspricht, die wir zunächst trainieren und dann indexieren und verstehen müssen“, sagt Lee. „Die Herausforderung liegt hier in der schieren Größe.“ Twelve Labs arbeitet mit AWS zusammen, um diese Herausforderung zu meistern und auf die Technologie und das Fachwissen zuzugreifen, die zum Erreichen seiner Ziele erforderlich sind.

Perzeptuelles Denken mit innovativer Technologie möglich machen

Twelve Labs nutzt Amazon SageMaker HyperPod, um seine Modelle effizienter zu trainieren und zu skalieren. Unternehmen nutzen SageMaker HyperPod, um Basismodelle über Wochen oder sogar Monate hinweg zu trainieren, während sie den Zustand des Clusters aktiv überwachen und die automatisierte Ausfallsicherheit von Knoten und Jobs nutzen. Wenn ein fehlerhafter Knoten erkannt wird, wird er automatisch ersetzt und das Modelltraining fortgesetzt, wodurch bis zu 40 Prozent der Trainingszeit eingespart werden.

„Eine der größten Herausforderungen beim Aufbau dieser Modelle besteht darin, dass wir mit wirklich leistungsstarken Maschinen in einem unglaublichen Maßstab arbeiten, von Hunderten von GPUs bis zu Zehntausenden von CPUs“, sagt Lee. „Obwohl diese Maschinen wirklich gut gebaut und robust sind, gibt es viele Hardware- und Knotenausfälle.“

„Wir arbeiten eng mit dem SageMaker HyperPod-Team zusammen. Wir nutzen die Ausfallsicherheit und die verteilte Trainingsinfrastruktur, die AWS aufgebaut hat. So können wir GPUs hochfahren, unsere Modelle so schnell wie möglich trainieren und ausliefern“, sagt Lee. „Die Ausfallsicherheit von SageMaker HyperPod, die Möglichkeit, ausgefallene Knoten zu reparieren und im Grunde genommen Hochleistungsrechner auszulagern, hat uns sehr überzeugt.“

Das Team von Twelve Labs nutzt außerdem AWS Elemental MediaConvert für die cloudbasierte Transkodierung von Videos, wodurch die Wartung einer Infrastruktur für die Videoverarbeitung entfällt. „Dank der Streaming-Infrastruktur von AWS Elemental MediaConvert können wir uns auf das konzentrieren, was wir wirklich gut können“, sagt Lee.

Twelve Labs bietet außerdem eine umfassende Integration mit Amazon Simple Storage Service (Amazon S3), einem Objektspeicher-Service, der branchenführende Skalierbarkeit, Datenverfügbarkeit, Sicherheit und Leistung bietet. „Unsere Kunden schätzen die nahtlose Integration der Workflows von Twelve Labs und S3 sehr“, so Lee. „Wenn Sie den Großteil Ihrer Daten auf S3 speichern, können wir Ihre Videodaten nahtlos abrufen, indizieren, einbetten und eine reibungslose Suche ermöglichen.“

Wachstum in den Mittelpunkt stellen

AWS hat Twelve Labs auch durch AWS Activate bei seinem Wachstum unterstützt, einem Flaggschiff-Programm, das Cloud-Guthaben, technischen Support und Business-Mentoring für Startups bietet. Das AWS Startups-Team besteht aus Gründern, Entwicklern und Visionären, die nicht nur die Herausforderungen beim Aufbau eines Startups verstehen, sondern diese auch selbst erlebt haben und über die Erfahrung verfügen, andere auf ihrem Weg zu unterstützen. Dazu gehören die Erkenntnis, welche AWS-Services für ihren Anwendungsfall geeignet sind, die Finanzierung eines ersten Proof-of-Concept und vieles mehr.

Ein wichtiger Teil von AWS Activate besteht darin, Startups bei der Entwicklung von Markteinführungsstrategien zu unterstützen und ihre Exposition gegenüber neuen Kunden zu erhöhen. Im Rahmen dieses Prozesses ist Twelve Labs dem AWS Marketplace beigetreten, einem kuratierten digitalen Shop, über den das Unternehmen seine Video-Intelligence-Services nahtlos an einen globalen Kundenstamm liefern kann. Unternehmen jeder Größe können nun den AWS Marketplace nutzen, um Produkte von Twelve Labs schnell zu finden, auszuprobieren, zu kaufen, bereitzustellen und zu verwalten.

KI, die die Welt so sieht, wie wir sie sehen

Auch in Zukunft wird Twelve Labs mit AWS zusammenarbeiten und neue Wege im Bereich der KI-gestützten Video-Intelligence beschreiten. „Der überzeugendste Grund für die Zusammenarbeit mit AWS ist das gemeinsame Verständnis für unsere Kunden, die mit Petabytes oder sogar Exabytes an Videodaten zu tun haben“, so Lee.

„AWS hat uns die Rechenleistung und den Support zur Verfügung gestellt, um die Herausforderungen der multimodalen KI zu meistern und Videos zugänglicher zu machen. Wir freuen uns auf eine fruchtbare Zusammenarbeit in den kommenden Jahren, während wir unsere Innovationen fortsetzen und weltweit expandieren“, so Lee. „Wir können unser Modelltraining beschleunigen, unsere Lösung sicher an Tausende von Entwicklern weltweit liefern und die Rechenkosten kontrollieren – und das alles, während wir mit generativer KI die Grenzen des Videoverständnisses und der Videoerstellung erweitern.“

Im Rahmen eines dreijährigen strategischen Kooperationsvertrags (SCA) arbeitet das Unternehmen nun mit AWS zusammen, um seine Modelltrainingsfähigkeiten weiter zu verbessern und seine Modelle in neuen Branchen wie dem Gesundheitswesen und der Fertigung bereitzustellen. „Wir möchten der visuelle Kortex für alle zukünftigen KI-Agenten sein – Agenten, die die Welt so sehen müssen, wie wir sie sehen“, sagt Lee.

Wie war dieser Inhalt?