亚马逊AWS官方博客

在 AWS 上一键部署 DeepSeek 蒸馏模型

|

介绍

亚马逊云科技一直在持续关注客户需求与技术发展,并为客户提供丰富且有深度的模型。随着 DeepSeek V3 以及 R1 模型的出现,亚马逊云科技也即时为客户提供了部署方案。目前,您可以在 Amazon Bedrock、Amazon SageMaker AI 以及 EC2 中部署 DeepSeek-R1 模型。Amazon Bedrock 最适合那些希望使用 API 快速集成预训练模型的团队;Amazon SageMaker AI 则非常适合自己进行高级定制、训练和部署、调用基础设施的团队。

本文通过 CloudFormation 模版在 Amazon EC2 上一键部署 DeepSeek-R1 Llama 8B 模型。这个方案易于搭建,让您轻松尝鲜私有化的 DeepSeek 模型。您需要大约半个小时来完成整个部署方案,本文提供了中国区和海外美东 1 区域两个部署模版,同时您也可以修改模版,部署在其他有 GPU 资源的区域中。

方案部署

为降低复杂度,我们已经准备好 CloudFormation 模板文件,快速简单的完成实验环境部署。 后续,如果大家希望深入了解整个部署过程,也可以通过代码进行分段部署。 接下来我们开始部署环境。请按照如下步骤进行:

1. 在 AWS 控制台中进入 CloudFormation 服务,点击“创建堆栈”

|

2. 模板源选择“上传模版文件”。根据您的账号选择以下 yaml 文件进行下载,并上传,上传后点击下一步。

|

3. 输入堆栈名称,选择 VPC 和 Subnet,点击下一步

|

4. 保持默认设置,点击下一步

|

5. 选择“我确认……”,点击下一步

|

6. 稍等几分钟,待部署完成,在“输出”标签中,即可看到“PublicIP”,即 DeepSeek OpenWebUI 应用的 IP 地址

|

复制该 IP 地址,到浏览器地址栏中,输入 http://IP地址:3001,即可打开页面。

7. 点击 Get Started 进入下一步。

|

8. 在 OpenWebUI 页面中点击下一步,在搜索框中输入 Ollama,保持默认配置,继续下一步

|

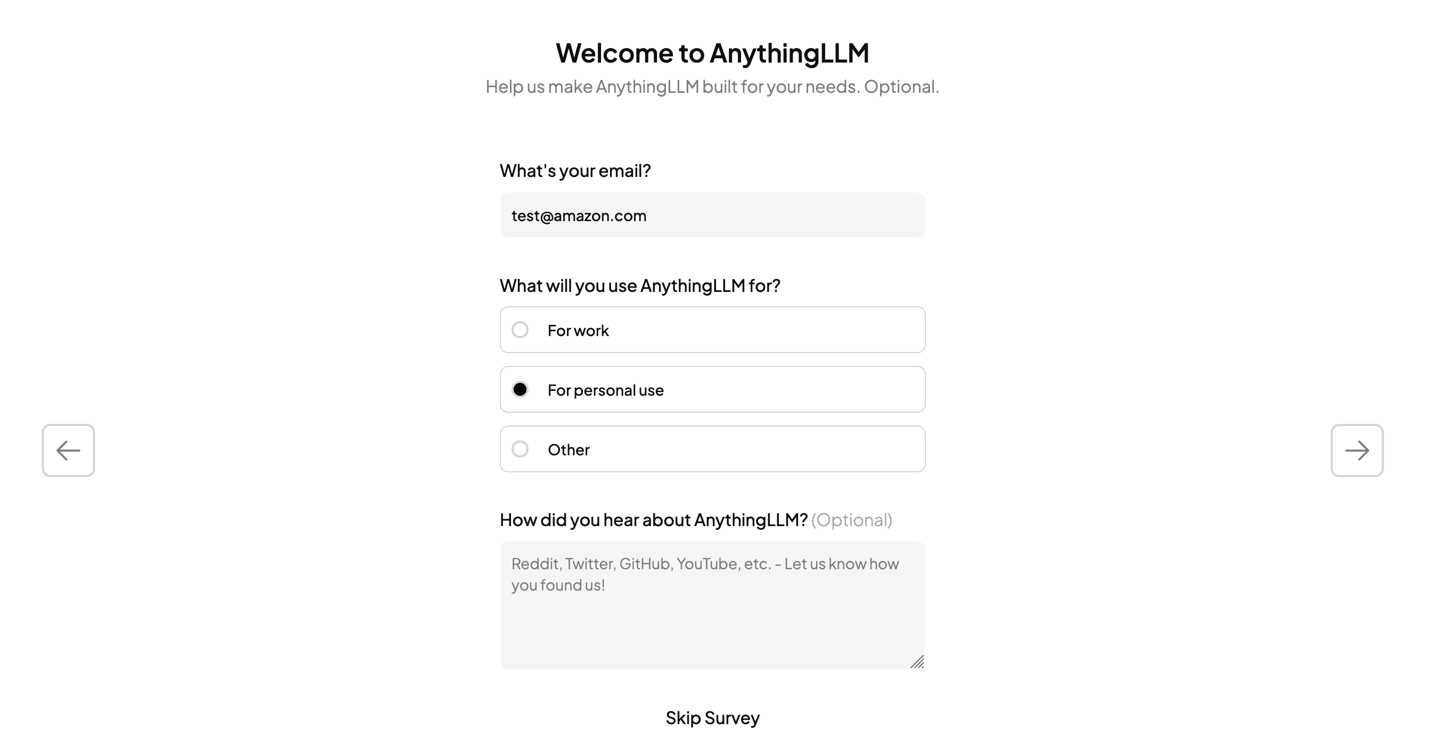

根据情况选择设置,继续下一步。在下一页随意输入一个邮箱,并选择 For personal use。

|

|

在这一步中创建 workspace,随意输入一个名字,这里输入的是 test。

|

在右侧导航栏中选择刚刚创建的 workspace。您可以在这个 workspace 中和 DeepSeek-R1 8B 模型进行交互。

|

结语

本文讲解了在 Amazon EC2 上使用 GPU 实例私有化部署蒸馏后的 DeepSeek-R1 LLama 8B 模型。如您有更多需求,如使用 GPU 部署大参数模型如 70B、微调 DeepSeek 模型等,欢迎您联系亚马逊云科技客户经理,期待您的咨询和反馈,我们会与您进一步探讨。

*前述特定亚马逊云科技生成式人工智能相关的服务仅在亚马逊云科技海外区域可用,亚马逊云科技中国仅为帮助您了解行业前沿技术和发展海外业务选择推介该服务。