亚马逊AWS官方博客

Amazon Bedrock 上的模型擂台赛:DeepSeek、Nova、Claude,谁是最强文本审核大模型?

|

前言

随着互联网和移动互联网的快速发展,用户生成内容(UGC)的数量呈现出爆炸式增长。无论是社交媒体平台、电子商务网站,还是在线视频分享平台,用户生成的文字、图像、视频等内容都在不断增加。这些内容中可能包含有害、违法或不当的信息,对平台的品牌形象、用户体验和社会环境都可能产生负面影响。因此,对用户生成内容进行及时、准确的审核尤为重要。

然而,传统的人工审核方式已经难以满足当前内容审核的巨大需求。人工审核不仅成本高昂、效率低下,而且容易受到主观因素的影响,审核质量和一致性难以保证。此外,随着审核内容的多模态化(文字、图像、视频等)和多语种化,人工审核的挑战进一步加大。在这种背景下,生成式人工智能(Generative AI)技术为内容审核带来了全新的解决方案。基于大语言模型和多模态模型的生成式 AI 技术,可以自动、高效、准确地审核海量的用户生成内容,识别出有害、违规或不当的内容,从而保护平台的健康环境和用户体验。

生成式 AI 在内容审核领域的应用不仅可以大幅降低审核成本、提高审核效率,而且可以通过模型优化和持续学习,不断提升审核的准确性和一致性。同时,生成式 AI 技术还可以实现内容审核的自动化和智能化,减轻人工的工作负担,释放更多人力资源投入到其他高价值的工作中。

本文将探讨如何使用亚马逊云科技 Amazon Bedrock 上提供的生成式 AI 大模型进行文本内容审核。本文将使用同一文本审核测试数据集,从审核准确率、审核时延以及审核成本等多项指标全面评估 Amazon Bedrock 上不同大模型的表现差异,包括 DeepSeek 系列模型、亚马逊自研大模型 Nova 系列、Anthropic 的 Claude 3.x 系列模型,对比分析不同模型在不同应用场景下的优势,为您选择和构建合适的基于大模型的文本审核解决方案提供洞见与参考,本文提供了一套完整的部署测试代码,您可以更改代码中的数据与提示词进行自定义的测试。

此外,亚马逊云科技提供了一系列托管人工智能服务,包括 Amazon Rekognition、Amazon Comprehend、Amazon Transcribe、Amazon Translate,以及其他技术,来帮助您快速打造自动化智能化多模态内容审核方案,包括图像、视频、文本和音频审核工作流程,详情参考博客。

DeepSeek 模型访问及说明

DeepSeek 是中国 AI 初创公司,其于 2024 年 12 月推出了 DeepSeek-V3,随后于 2025 年 1 月 20 日发布了 DeepSeek-R1、DeepSeek-R1-Zero(拥有 6710 亿参数)以及 1.5-70 亿参数不等的 DeepSeek-R1-Distill 模型。这些模型均可公开获取,据称比同类模型便宜 90-95%,更具成本效益。DeepSeek 称,其系列模型以创新的训练技术(如强化学习)而突出,具有出色的推理能力。

您可以使用您的海外区亚马逊云科技账号在 Amazon Bedrock 和 Amazon SageMaker AI 上部署或访问 DeepSeek-R1 模型以系列蒸馏模型。Amazon Bedrock 最适合希望通过 API 快速集成预训练基础模型的团队。Amazon SageMaker AI 则更适合需要高级定制、训练和部署,并可访问底层基础设施的组织。此外,您还可以使用 AWS Trainium 和 AWS Inferentia 通过 Amazon Elastic Compute Cloud (Amazon EC2)或 Amazon SageMaker AI,具成本效益地部署 DeepSeek-R1-Distill 模型,从而进行文本审核。

如果您是亚马逊云科技中国区账号的拥有者,您可以通过亚马逊云科技合作伙伴硅基流动,在亚马逊云科技 Marketplace 中国区域上架的“SiliconCloud – Models as a Service”产品访问 DeepSeek 全系列模型,同时,您可以选择在 Amazon SageMaker AI 或 Amazon EC2 私有化部署 DeepSeek 全系列模型,进行文本审核。

测试数据说明

实验使用 Hugging Face 数据作为测试数据,测试数据共 1680 条,由毒性标签(色情、仇恨、暴力、骚扰、自残、性/未成年人、仇恨/威胁、暴力)和非毒性标签组成。标签详细说明如下表格所示。

| Category | Label | Definition | |

| 1 | sexual | S |

Content meant to arouse sexual excitement, such as the description of sexual activity, or that promotes sexual services (excluding sex education and wellness). |

| 2 | hate | H |

Content that expresses, incites, or promotes hate based on race, gender, ethnicity, religion, nationality, sexual orientation, disability status, or caste. |

| 3 | violence | V |

Content that promotes or glorifies violence or celebrates the suffering or humiliation of others. |

| 4 | harassment | HR |

Content that may be used to torment or annoy individuals in real life, or make harassment more likely to occur. |

| 5 | self-harm | SH |

Content that promotes, encourages, or depicts acts of self-harm, such as suicide, cutting, and eating disorders. |

| 6 | sexual/minors | S3 |

Sexual content that includes an individual who is under 18 years old. |

| 7 | hate/threatening | H2 |

Hateful content that also includes violence or serious harm towards the targeted group. |

| 8 | violence/graphic | V2 |

Violent content that depicts death, violence, or serious physical injury in extreme graphic detail. |

| 9 | no toxic | Good | There are no toxic elements in this content. |

DeepSeek 系列模型在文本审核上的对比

本次试验使用 Amazon Marketplace Silliconflow API 以及 Amazon Bedrock DeepSeek-R1 API 来调用模型进行。

从准确率来看,Deepseek-R1、DeepSeek-V3、Deepseek Distilled Llama70B,以及 DeepSeek Distilled Qwen 32B 都达到了 90% 以上的准确率。DeepSeek-R1 准确率最高,达到了 97.14%。值得注意的是,DeepSeek Distilled Qwen 32B 的准确率为 92.86%,超过了 Deepseek Distilled Llama 70B,仅次于 Deepseek-R1。

从首字节延迟来看,DeepSeek Distilled Qwen 32B 的速度为 0.29/ms,比 DeepSeek-R1 快一倍。

从价格上来看,每次输入 500 个 token,DeepSeek 系列模型输出 570 个 token(1 character = 0.3 token)。在一万次调用下,总共消耗 5M 的输入 token 以及 5.7 M 的输出 token。使用亚马逊 Marketplace 硅基流动产品的 DeepSeek API 来计费,DeepSeek Distilled Qwen 32B 和 DeepSeek-V3 的价格大约仅为 DeepSeek-R1 硅基流动 API 的 13% 左右。Bedrock DeepSeek-R1 API 的价格虽然高于 DeepSeek-R1 硅基流动 API,但总延迟降低 52.6%(21.55s → 10.22s),首字节响应速度提升 40%。

因此,从成本优化的角度来看,DeepSeek Distilled Qwen 32B、DeepSeek-R1进行文本审核的成本更优;如果您没有对模型追溯性的需求,则可以使用 DeepSeek-V3模型,在保证高准确性的同时大幅降低了审核成本。

注:DeepSeek 硅基流动 API 仅限中国区账号使用。海外区账号可以使用 Bedrock DeepSeek-R1 API。

| DeepSeek 系列模型 | 准确率 | total latency/s | ttft/s | API 每百万 token 调用价格 | EC2 部署价格/小时 | 部署方式 | 机型 |

| DeepSeek Distilled Qwen1.5B | 11.43% | 2.31 | 0.04 | ¥1.50 | $1.21 | Amazon EC2 | g5.2xlarge |

| DeepSeek Distilled Qwen7B | 65.71% | 3.4 | 0.09 | ¥3.75 | $1.21 | Amazon EC2 | g5.2xlarge |

| DeepSeek Distilled Qwen14B | 84.29% | 16.002 | 0.62 | ¥7.49 | $5.67 | Amazon EC2 | g5.12xlarge |

| DeepSeek Distilled Qwen32B | 92.86% | 11.26 | 0.26 | ¥12.60 | $5.67 | Amazon EC2 | g5.12xlarge |

| DeepSeek Distilled Llama8B | 72.86% | 15.53 | 0.39 | ¥4.49 | $1.21 | Amazon EC2 | g5.2xlarge |

| DeepSeek Distilled Llama70B | 91.42% | 2.95 | 0.3 | ¥44.19 | $4.60 | Amazon EC2 | g6.12xlarge |

| Deepseek-R1 硅基流动 API | 97.14% | 21.55 | 0.4241 | ¥111.20 | NaN | Amazon Marketplace 硅基流动 API | NaN |

| Bedrock DeepSeek-R1 API | 97.14% | 10.22 | 0.25 | ¥271.40 | NaN | Amazon Bedrock DeepSeek API | NaN |

| DeepSeek-V3 | 95.71% | 8.2 | 0.75 | ¥15.28 | NaN | Amazon Marketplace 硅基流动 API | NaN |

Table 注释:

- 准确率:判断文本是否存在毒性(及是否存在黄暴、侮辱、仇恨言论)的准确率。

- total latency:从提问模型到模型回答完毕的延迟时间。其中 DeepSeek-R1 蒸馏模型使用 Amazon EC2 机器部署,DeepSeek-R1 使用 Amazon Marketplace 硅基流动 API 或 Amazon Bedrock DeepSeek API 部署,DeepSeek-V3 使用 Amazon Marketplace 硅基流动 API。延迟时间会受到部署方式的影响。

- ttft:从提问模型到模型输出第一个字节的延迟时间。其中 DeepSeek-R1 蒸馏模型使用 Amazon EC2 机器部署,DeepSeek-R1 使用 Amazon Marketplace 硅基流动 API,或 Amazon Bedrock DeepSeek API 部署,DeepSeek-V3 使用 Amazon Marketplace 硅基流动 API。ttft 会受到部署方式的影响。

- API 调用价格:按照每百万输入和输出 token 计费。使用 Amazon Marketplace 硅基流动 API 或 Amazon Bedrock DeepSeek API 的调用价格。其中只有 Bedrock DeepSeek-R1 API 使用 Amazon Bedrock 价格计费,其余模型使用 Amazon Marketplace 硅基流动的计费方式。

- EC2 部署价格/hr:蒸馏系列模型每小时使用 EC2 机器的价格。

- 机型:部署蒸馏系列模型的机型。

模型准确率对比

在文本审核任务中,DeepSeek 系列模型展现出不同水平的准确率表现。高准确率模型中,DeepSeek-R1 以 97.14% 的准确率领先,其次是 DeepSeek-V3,达到 95.71%,DeepSeek Distilled Qwen 32B 和 DeepSeek Distilled Llama 70B 分别达到 92.86% 和 91.42% 的准确率。值得注意的是,DeepSeek Distilled Qwen 32B 的准确率为 92.86%,超过了 DeepSeek Distilled Llama 70B,仅次于 DeepSeek-R1。

延迟性能对比

在 API 调用部署方式下,三种模型的延迟性能各有特点。从数据可以看出,Bedrock DeepSeek-R1 API 的首字节响应速度比硅基流动 API 版本快约 40%,总延迟也比硅基流动版本降低了 52.6%。虽然 DeepSeek-V3 在总延迟方面表现最佳,但其首字节响应速度相对较慢。

在 EC2 自部署环境中,各模型的延迟表现差异明显。DeepSeek Distilled Llama 70B 在 g6.12xlarge 实例上的总延迟仅为 2.95 秒,表现最佳;DeepSeek Distilled Qwen 32B 在 g5.12xlarge 上的首字节延迟为 0.26 秒,响应速度优秀,总延迟为 11.26 秒;DeepSeek Distilled Qwen 14B 在相同实例上的首字节延迟为 0.62 秒,总延迟达到 16 秒;DeepSeek Distilled Llama 8B 在 g5.2xlarge 上的首字节延迟为 0.39 秒,总延迟为 15.53 秒;DeepSeek Distilled Qwen 7B 和 1.5B 在 g5.2xlarge 上的首字节延迟分别为 0.09 秒和 0.04 秒,总延迟分别为 3.4 秒和 2.31 秒。这说明小型模型通常具有更低的首字节延迟,而大型模型在总体响应时间方面可能更有优势,特别是在适合的硬件配置下。

成本对比分析

API 调用成本方面,DeepSeek-V3 的价格仅为 DeepSeek-R1 硅基流动 API 的约 13.7%,而准确率仅下降 1.43%,提供了极具吸引力的性价比。虽然 Bedrock DeepSeek-R1 API 价格最高,但它提供了更好的延迟性能,适合对响应速度有较高要求的应用场景。

EC2 部署成本方面,不同模型根据所需实例类型而有所差异。DeepSeek Distilled Qwen 32B 提供了最佳的准确率与成本平衡,而 DeepSeek Distilled Llama 70B 在稍低的成本下也能提供接近的准确率表现。小型模型虽然部署成本低,但准确率显著下降,不适合对准确性要求较高的应用场景。

DeekSeek Vs Claude Vs Nova 在文本审核上的对比

接下来我们选择在该数据集上综合表现不错的 DeepSeek-R1、DeepSeek-V3 来和 Amazon 自研 Nova 系列模型以及业界领先模型 Claude3.x 系列模型做对比。

| 准确率 | total latency/s | ttft/s | 价格/1 万次调用 | 平均输入 token/次 | 平均输出 token/次 | 部署方式 | |

| Deepseek-V3 | 95.71% | 8.2 | 0.75 | ¥15.28 | 500 | 66 | Amazon Marketplace 硅基流动 API |

| Bedrock DeepSeek R1 API | 97.14% | 10.22 | 0.25 | ¥271.40 | 500 | 570 | Amazon Bedrock API |

| DeepSeek-R1 硅基流动 API | 97.14% | 21.55 | 0.4241 | ¥111.20 | 500 | 570 | Amazon Marketplace 硅基流动 API |

| Claude 3.5 Haiku | 91.43% | 3.53 | 0.46 | ¥49.43 | 500 | 175 | Amazon Bedrock API |

| Claude 3.5 Sonnet | 95.71% | 4.37 | 0.53 | ¥134.81 | 500 | 150 | Amazon Bedrock API |

| Claude 3.7 Sonnet | 97.14% | 3.81 | 0.73 | ¥134.81 | 500 | 150 | Amazon Bedrock API |

| Amazon Nova Pro | 95.71% | 2.65 | 0.43 | ¥45.56 | 500 | 73 | Amazon Bedrock API |

| Amazon Nova Lite | 94.28% | 1.1 | 0.38 | ¥3.62 | 500 | 85 | Amazon Bedrock API |

模型准确率对比

在文本审核任务中,各模型展现出不同水平的准确率表现。Claude 3.7 Sonnet 和 DeepSeek-R1 并列第一,均达到了 97.14%的最高准确率。其次是 Amazon Nova Pro、Claude 3.5 Sonnet 和 DeepSeek-V3,这三款模型均达到了 95.71% 的准确率。考虑到在低延迟和价格方面的优势,Amazon Nova Lite 的表现也较为出色。

延迟性能对比

延迟性能方面,Amazon Nova Lite 以 1.1 秒的总延迟和 0.38 秒的首字节延迟(ttft)表现最佳,响应速度极快。Amazon Nova Pro 也表现出色,总延迟仅为 2.65 秒,首字节延迟为 0.43 秒。Claude 系列模型的延迟表现也很优秀,特别是 Claude 3.7 Sonnet,准确率最高的同时总延迟仅为 3.81 秒。

相比之下,DeepSeek 系列模型的延迟表现差异较大。DeepSeek-V3 的总延迟为 8.2 秒,首字节延迟为 0.75 秒;DeepSeek-R1 模型不可避免的 reasoning 过程会导致延迟的增加。Bedrock DeepSeek-R1 API 的总延迟为 10.22 秒,但首字节延迟仅为 0.25 秒,表明其初始响应速度很快;而 DeepSeek-R1 硅基流动 API 的总延迟最高。这表明在延迟性能方面,Amazon Nova 系列和 Claude 系列模型明显优于 DeepSeek 系列模型,特别是在总响应时间方面。

成本对比分析

在成本效益方面,各模型之间的差异更为显著。Amazon Nova Lite 以每万次调用仅需 ¥3.62 的价格遥遥领先,成为最具成本效益的选择。Amazon Nova Pro 的价格为每万次调用 ¥45.56,虽然比 Nova Lite 高,但考虑到其 95.71% 的高准确率,仍然提供了很好的性价比。

Claude 3.7 Sonnet 的价格与 DeepSeek-R1 硅基流动 API 相差不会太大,同时 Claude 3.7 Sonnet 相较于 DeepSeek-R1 的优势是可以关闭 reasoning 功能或是控制 reasoning 的输出大小,可以通过调整 max output token 来更好地控制成本。而 Amazon Bedrock DeepSeek-R1 API 则可以提供相同智力水平的情况下,相较于硅基流动 API 更低的延迟(10.22s)。

值得注意的是,DeepSeek-R1 系列模型每次调用平均输出 570 个 token,明显高于其他模型:Claude 系列为 150-175 个 token,Nova 系列和 DeepSeek-V3 仅为 66-85 个 token。这种”overthinking”现象显著增加了 DeepSeek-R1 的使用成本,特别是在大规模调用场景下。

例子

实验使用简单的提示词,将数据分类标签以及文本内容提供给模型,让模型判断输入内容是否存在毒性内容,要求模型为内容做标签分类并提供解释。

通过测评发现,所有测评模型都存在可能过于简单地关注到了一些关键词语,而忽视了整体语境的中立性的问题。下面提供的两个例子的特性是,内容虽也提到了毒性词汇,但整体来看,并不是在直接传播负面观点或有害内容,而是在客观描述一个虚构的背景情节。以 DeepSeek-R1 的回答为例,模型并没有办法判断出这段内容的中立性,反而错误的将内容标注为存在毒性。

建议使用 few-shot,prompt-engineering 等方式提升模型在此场景下的准确性。

例子 1:

DeepSeek-R1 回答:

例子 2:

DeepSeek-R1 回答:

实验步骤

实验步骤将演示使用 Amazon Bedrock API 调用 DeepSeek-R1 的方式,在 Amazon SageMaker AI 的 Notebook 中进行实验。

如果您是首次使用 DeepSeek-R1 模型,请按照以下步骤操作:

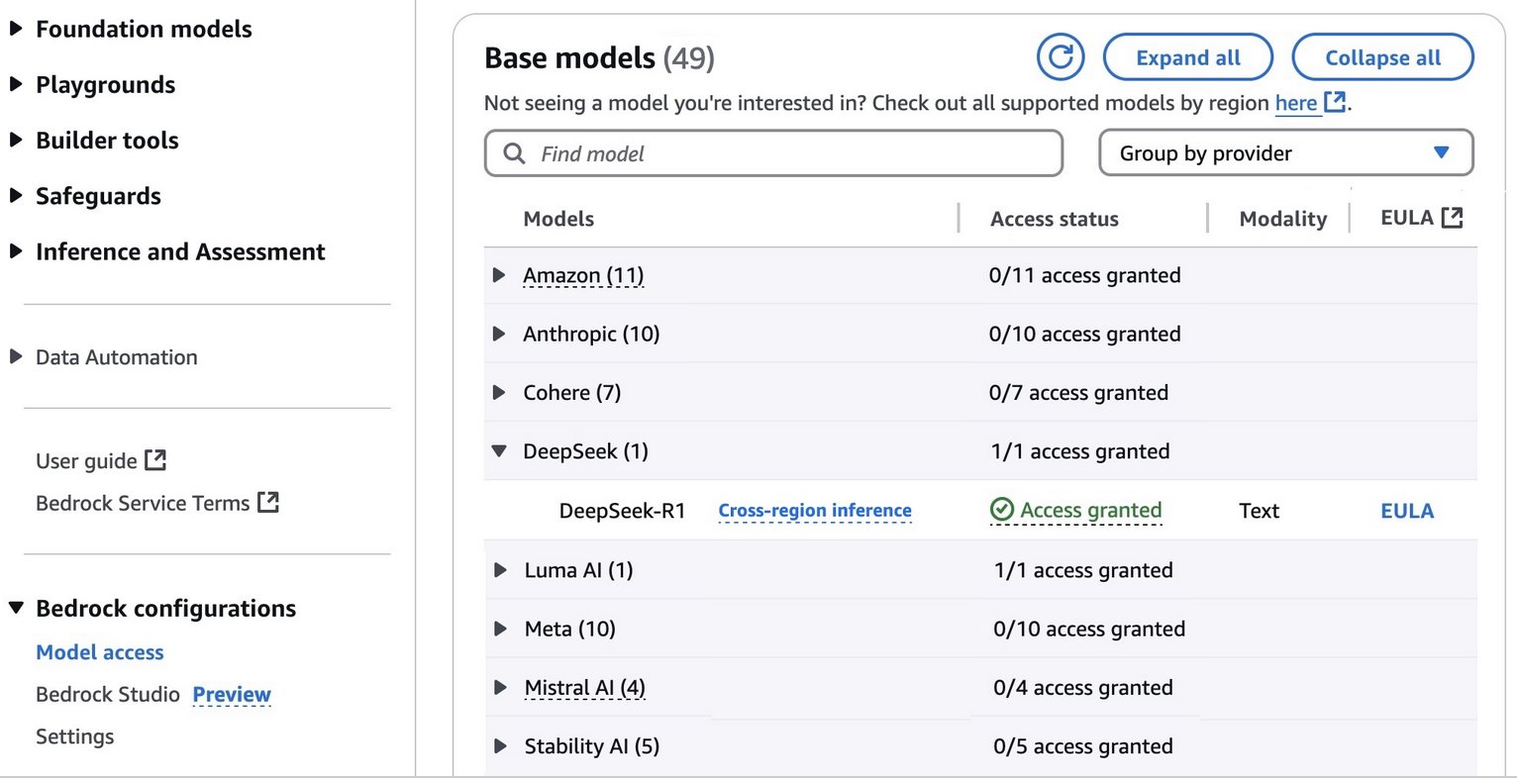

- 前往 Amazon Bedrock 控制台

- 在左侧导航栏的 Bedrock 配置下,选择“模型访问(Model access)”选项

- 要访问完全托管的 DeepSeek-R1 模型,请在 DeepSeek 类别中申请 DeepSeek-R1 的访问权限

- 申请批准后,您将获得在 Amazon Bedrock 中使用该模型的权限

完成这些步骤后,您就可以开始使用 DeepSeek-R1 模型了。

|

- 现在您可以前往 Amazon SageMaker AI 控制台,在控制台中左侧导航栏处选择 Notebooks,点击创建笔记本实例。填入笔记本实例名称,笔记本实例类型选择 ml.t3.large 即可。其余选项默认,点击创建笔记本实例即可。笔记本实例创建需要等待 2-3 分钟。

数据准备代码

测试部分代码

统计实验结果

- 运行代码即可。

总结

应用场景建议:

- 对准确率要求极高,且预算充足:选择硅基流动 DeepSeek-R1、Amazon Bedrock DeepSeek-R1 或 Claude 3.7 Sonnet

- 需要平衡准确率与成本:选择 DeepSeek-V3 或 DeepSeek Distilled Qwen 32B

- 需要低延迟、高性价比:选择 Amazon Nova Lite

- 需要控制输出 token 以优化成本:选择 Claude 3.7 Sonnet

本次评测为企业选择适合其内容审核需求的 AI 模型提供了参考。随着 GenAI 技术的不断发展,我们期待这些模型在准确性、效率和成本方面能够取得更大的突破,为内容审核领域带来更多创新解决方案。

*前述特定亚马逊云科技生成式人工智能相关的服务仅在亚马逊云科技海外区域可用,亚马逊云科技中国仅为帮助您了解行业前沿技术和发展海外业务选择推介该服务。